深度解码OpenAI的2025野心:Codex重生与GPT-5 APIKey获取调用示例

导语:

2025年,AI辅助编程的浪潮正以前所未有的姿态席卷而来。对于我们每一位开发者而言,这不仅仅是工具箱里多了几个新玩具,更是一场深刻的工作范式革命。在这场变革的中心,OpenAI再次投下了一颗重磅炸弹:一度沉寂的Codex平台,在GPT-5的强力驱动下,以“软件工程代理”的全新身份王者归来。

这不只是一次简单的产品升级。它标志着一个关键的行业转向——从“生成式AI”到“代理式AI”的进化,AI的角色正从一个听话的“代码补全工具”转变为一个能够独立思考、规划并执行复杂任务的“虚拟队友”。

在这篇文章里,我们将一起深入探索这场变革的全貌。我们将拨开时间的迷雾,回顾Codex从诞生、“死亡”到重生的传奇历程;我们将像拆解精密仪器一样,剖析2025年Codex平台的混合架构与各大组件;我们还将直击其核心引擎——性能登顶的GPT-5模型,并为你带来一份详尽的API实操指南。最后,我们会将目光投向更广阔的战场,分析Codex在与Claude、Gemini等巨头的激烈竞争中,如何凭借其独特的生态系统战略,一步步实现自己的宏伟蓝图。

准备好了吗?让我们一起踏上这场探索之旅,洞见AI时代软件开发的未来。

第一部分:Codex的重生:从代码生成器到自主代理的惊险一跃

要理解今天Codex平台的战略地位,我们必须把时钟拨回到过去。它的故事并非一帆风顺,而是一段充满了开创、沉寂与重生的戏剧性旅程。正是最初那次看似突然的“死亡”,才为其后来的华丽转身铺平了道路。

1.1 初代Codex (2021-2023):梦开始的地方

2021年,初代Codex的问世,是AI编程领域的一座灯塔。它基于GPT-3,并在海量的GitHub代码上进行了精心的微调,从而获得了将自然语言“咒语”翻译成代码“魔法”的能力。

你只需要写下一行注释,比如 // 计算给定窗口大小的数组的移动平均值,Codex就能心领神会地生成完整的代码实现。这在当时看来近乎神奇,也正是这项能力,使其成为了初代GitHub Copilot背后的大脑,正式开启了AI编码助手的大时代。

然而,回过头看,这位先驱本质上更像一个“代码翻译官”或“补全工具”,而非一个真正的“工程师”。它在单次交互中表现出色,但面对需要多步推理或复杂逻辑的“项目”时,常常会力不从心,甚至生成一些有安全隐患的“豆腐渣工程”。这恰恰暴露了第一代生成式AI的局限,也为未来的进化埋下了伏笔。

1.2 2023年的“死亡”:一次深思熟虑的战略撤退

2023年3月,一则简短的通知宣告了Codex API的终结。OpenAI建议用户转向更强大、更通用的GPT-3.5-Turbo模型。这个决定在开发者社区,尤其是在依赖它进行研究的学术界,激起了千层浪。

这次“死亡”并非失败,而是一次蓄谋已久的战略转型。随着GPT-3.5和GPT-4的横空出世,初代Codex的底层技术已然落后。OpenAI意识到,与其维护一个略显过时的独立API,不如集中火力,将资源投入到下一代更全能的模型上。

更重要的是,这次暂停给了OpenAI一个宝贵的机会,去重新构想它在开发者工具领域的宏大布局。它不再满足于只提供一个简单的API接口,而是要构建一个深度集成、功能协同的强大生态。Codex的“死”,是为了以一种更强大的形态“生”。

1.3 2025年的归来:软件工程的“代理”时代

两年后,Codex如期归来,但已脱胎换骨。它不再是一个孤立的模型,而是一个被定义为“软件工程代理”的综合平台。这个新系统拥有了前所未有的自主性,能够像一个真正的团队成员一样,独立处理复杂任务:

- 实现一个新功能? 交给它。

- 修复一个棘手的Bug? 它来搞定。

- 梳理混乱的代码库? 没问题。

- 甚至是运行测试、提交PR供你审查? 全都包办。

这标志着从“代码建议”到“任务执行”的根本性飞跃。2025年的Codex所承载的,是OpenAI对未来的一个大胆设想:开发者不再需要手把手地指导AI,而是可以将整个项目委托给AI“队友”,让自己专注于更富创造力和战略性的顶层设计。

这一切的实现,都归功于GPT-5等底层模型在多步推理和工具使用能力上的巨大突破。可以说,Codex的重生,是AI模型能力达到新高度后,必然会发生的产品战略进化,它的目标,是重新定义人与AI在代码世界中的协作关系。

核心洞察:从“生成”到“行动”的范式转移

Codex的演进史,完美诠释了AI行业从 生成式AI (Generative AI) 到 代理式AI (Agentic AI) 的核心转变。

- 2021年的Codex是“生成”:你给一个指令,它生成一段代码。价值在于单次的、即时的创造。

- 2025年的Codex是“行动”:你给一个目标,它会自己规划、读取、修改、运行代码,并最终交付一个成果(比如一个PR)。价值在于多步骤的、自主的、以目标为导向的行动。

这种从“生成内容”到“完成任务”的转变,正是“代理化”的精髓所在。Codex用自己的“生死轮回”,为我们展示了AI工具的未来形态。

| 表1:OpenAI Codex的演进对比(2021年 vs. 2025年) | 特征 | Codex (2021-2023) | Codex (2025 平台) |

|---|---|---|---|

| 底层模型 | 基于GPT-3,在代码上进行微调 | 由o3和GPT-5的专门版本驱动 | |

| 访问方式 | 私人测试版API端点(已弃用) | 集成于ChatGPT订阅服务中;通过Web、CLI、IDE客户端访问 | |

| 核心功能 | 自然语言到代码的补全/翻译 | 自主任务执行(错误修复、功能实现、PR创建) | |

| 产品形态 | 通过API访问的单一模型 | 一个多组件平台(Web、CLI、IDE) | |

| 主要交互模式 | 单轮、同步的代码建议 | 多步、异步的任务委托 |

第二部分:拆解2025年的Codex平台:一个无处不在的AI开发系统

2025年的Codex不再是一个单一产品,而是一套围绕开发者工作流精心设计的集成工具生态。让我们逐一拆解它的核心组件,看看它们是如何协同作战的。

2.1 架构:云端大脑与本地触手的无缝协同

新版Codex采用了一种巧妙的混合架构,完美融合了本地开发的敏捷与云端计算的强大。系统由两部分组成:

- 本地组件:像Codex CLI和IDE扩展,它们运行在你的电脑上,能直接访问你的文件,响应迅速。

- 云端组件:以Codex Web为核心,运行在隔离的云端沙箱中,拥有强大的计算和推理能力。

这套架构最妙的地方在于“工作流的无缝转移”。你可以在IDE里写着代码,遇到一个复杂的重构任务,只需一键就能把它“扔”给云端的Codex代理去异步处理。等你泡杯咖啡回来,代码变更已经静静地躺在你的PR列表里了。这种灵活性,让开发者既能享受本地开发的沉浸感,又能将耗时费力的重活、累活外包给云端。

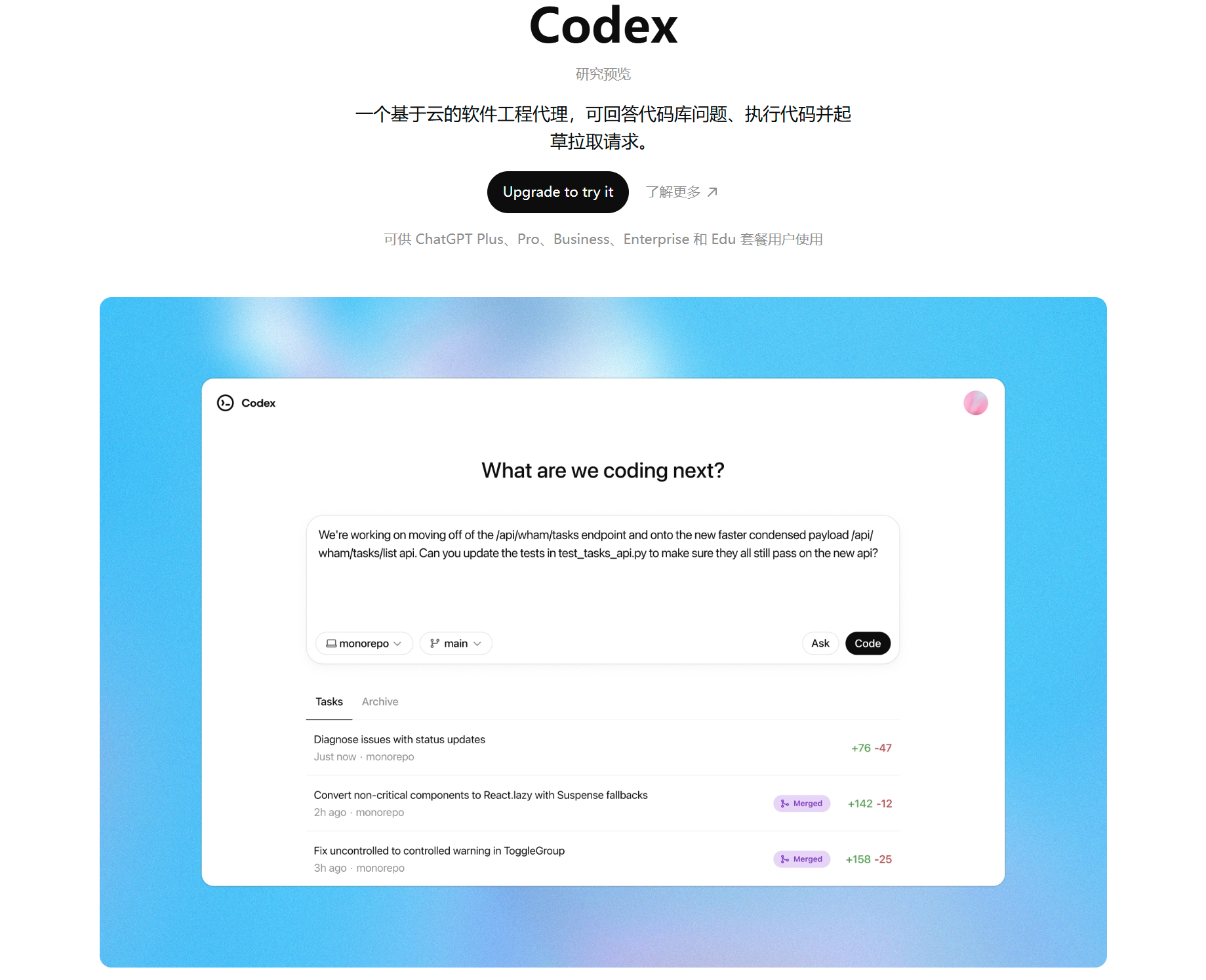

2.2 Codex Web:你的云端AI队友

Codex Web (chatgpt.com/codex) 是整个平台的大脑,也是实现“代理式”开发的核心界面。它的使命就是处理那些复杂的、需要长时间运行的大型任务。当你委托一个任务时,Codex会为你启动一个隔离且安全的云端沙箱容器。

这个沙箱环境经过了精心设计,默认禁止访问互联网,只使用白名单内的依赖,最大程度地保障了代码安全。最近的更新更是带来了几项“史诗级”增强:

- 容器缓存:将新任务的启动时间从近1分钟锐减至5秒,告别漫长等待。

- 环境自动配置:能自动识别并运行

npm install、pip install等命令,减少了40% 因环境问题导致的失败。 - 多模态输入:可以直接扔给它一张UI设计图,让它帮你实现前端界面,看图写代码成为现实。

无论是通过网页、IDE、手机App,甚至是在GitHub PR的评论区@它,你都能随时随地唤醒这个强大的云端队友。

2.3 Codex CLI:终端爱好者的开源利器

对于热爱命令行的“终端原生”开发者,OpenAI推出了开源的Codex CLI。它采用Apache 2.0许可证,完全拥抱开发者社区。你可以通过npm或brew轻松安装。

这款工具直接在你的本地终端运行,能与文件系统无缝交互,完美融入你最熟悉的工作流。它主要由Rust语言编写(占比高达97.1%),足见OpenAI对性能和稳定性的极致追求。它的出现,也让它成为了Anthropic Claude Code等终端AI工具的有力竞争者。

2.4 Codex IDE扩展:让AI融入你的每一次心跳

为了实现真正的“沉浸式”开发体验,官方IDE扩展必不可少。它支持VS Code及其生态(如Cursor),将Codex的强大能力以UI的形式无缝嵌入到你的编辑器中。

你可以用它进行实时的代码补全、本地重构、快速Debug,享受“结对编程”般的流畅。但它最重要的角色,是连接本地与云端的“传送门”。通过它,开发者可以一键将复杂任务委托给云端代理,实现了“实时辅助”与“异步委托”两种模式的完美融合。这绝不是一个简单的附加功能,而是整个平台协同工作的关键枢纽。

2.5 GitHub集成:AI代码审查员已上线

Codex与GitHub的深度集成,是它从个人工具迈向团队协作资产的决定性一步。授权后,Codex可以直接在你的代码仓库里“干活”。

最亮眼的功能莫过于智能代码审查。在PR或评论中@codex,它就会被唤醒,进行一次超越传统静态分析的深度审查。它能:

- 理解意图:检查代码变更是否与PR的描述目标一致。

- 全局分析:在整个代码库的上下文中评估影响,而不只是孤立地看几行改动。

- 动态验证:在某些情况下,甚至会运行代码来验证其行为是否符合预期。

这项功能让Codex成为了团队中一个不知疲倦、极其严谨的AI成员,有望极大提升代码质量和团队效率。

商业策略洞察:生生不息的“生态系统飞轮”

这套多组件架构的背后,隐藏着一个精妙的商业飞轮:

- 一个开发者可能被IDE扩展的便利所吸引,轻松入门。

- 当遇到复杂任务时,IDE会自然地引导他使用云端代理。

- 云端代理完成任务后提交了PR,他又会发现GitHub集成的代码审查功能非常强大。

- 为了将某些流程自动化,他开始使用CLI工具,进一步深度绑定。

所有这一切,都由同一个ChatGPT订阅驱动。每个组件都在增强其他组件的价值,从而创造出极强的用户粘性,将用户牢牢锁定在OpenAI的生态系统内。这是一种远比销售单一工具更高级的竞争策略。

表2:OpenAI Codex 2025平台组件对比

| 组件 | 执行环境 | 主要用例 | 交互模式 |

|---|---|---|---|

| Codex Web | 云端沙箱容器 | 委托复杂的、长时间运行的异步任务 | 对话式、面向任务的委托 |

| Codex CLI | 本地计算机(终端) | 脚本编写、自动化、终端原生工作流 | 命令行、提示驱动 |

| Codex IDE扩展 | 本地计算机(IDE) | 实时结对编程、代码生成、本地重构 | 交互式UI、编辑器内辅助 |

| GitHub集成 | GitHub平台 | 自动化代码审查、PR分析 | 协作式、事件驱动 |

第三部分:核心引擎:GPT-5,驱动一切的性能怪兽

Codex平台之所以能实现如此强大的代理能力,完全得益于其背后那颗无与伦比的“心脏”——GPT-5模型。

3.1 GPT-5揭幕:一次智能的巨大飞跃

2025年8月7日,GPT-5正式发布,被誉为一次“巨大的智能飞跃”。它在编码、数学、写作等多个维度都刷新了性能记录。

其架构的一大创新是在ChatGPT内部实现了一个“统一系统”。这个系统包含一个处理常规任务的高效基础模型,和一个专攻难题的深度推理模型(被称为“GPT-5 thinking”)。一个智能路由器会根据任务的复杂性,动态决定调用哪个模型。

对开发者而言,最激动人心的是,API直接开放了这个强大的推理模型,并引入了两个全新的控制参数:reasoning_effort(控制思考深度)和verbosity(控制回答详尽度)。这赋予了我们在性能、成本和速度之间进行精细权衡的超能力。

3.2 性能之巅:编码基准测试的绝对统治力

空口无凭,数据为证。GPT-5在各大权威编码基准测试中,都取得了SOTA(State-of-the-Art)的成绩。

- 在模拟真实世界GitHub问题的SWE-bench测试中,GPT-5的准确率达到了惊人的74.9%。

- 在另一项Aider Polyglot测试中,得分更是高达88%。

在一次独立的第三方评测中,GPT-5再次以68.8%的准确率力压群雄,显著领先于主要竞争对手Claude 4 Opus(67.6%)。这些冰冷的数字背后,是Codex代理在执行复杂软件任务时更强的可靠性和效率。

3.3 GPT-5与Codex:产品与引擎的共生

Codex与GPT-5的关系,就像一辆超级跑车和它的V12引擎。Codex是呈现给用户的产品,GPT-5是驱动它的核心技术。

OpenAI官方文档明确指出,Codex的客户端工具(如CLI)会为任务自动选择最优模型,而GPT-5是首选。并且,GPT-5经过了专门的微调,以便在像Codex这样的“代理式编码产品中大放异彩”。

因此,当你与Codex交互时,你体验到的所有高级功能——无论是修复Bug的缜密逻辑,还是理解大型代码库的深度洞察——都直接源于GPT-5强大的推理和规划能力。

3.4 专用模型:不止有GPT-5

虽然GPT-5是旗舰,但OpenAI也采取了更精细的模型策略。例如,他们推出了codex-mini-latest,一个基于o4-mini微调的、更具性价比的模型,专为CLI等场景设计。这表明OpenAI正在用最强的模型作为性能标杆和宣传亮点,同时在不同场景部署更小、更专业化的模型,以实现成本与性能的最佳平衡。

深度思考:性能与生产力的悖论

尽管GPT-5在基准测试中大杀四方,但一项来自METR的独立研究揭示了一个发人深省的悖论:对于经验丰富的开发者,在处理高质量、要求严苛的真实项目时,使用这些强大的AI工具反而可能导致效率下降19%。

原因何在?研究推测,像SWE-bench这样的基准测试,任务是自包含的,评分是自动的。而真实世界的开发,不仅要代码能跑通,还要满足代码风格、测试覆盖、文档规范等大量隐性要求。

这就带来了一个关键问题:管理AI、验证其输出、修正其“小聪明”所带来的“心智开销”,有时可能会超过它在写代码上节省的时间。

这个悖论提醒我们,如何将AI工具有效地融入成熟的工程流程,避免“AI管理成本”反噬生产力,将是所有技术团队需要严肃面对的挑战。

好的,我们接着往下。这是文章剩余部分的润色优化版本,力求与前文风格保持一致,为你呈现一篇完整、流畅且充满洞察力的深度好文。

第四部分:如何拥有Codex?订阅、API与两种开发者之道

搞清楚了Codex是什么,下一个问题自然是:我该如何用上它?OpenAI为我们铺设了两条截然不同的道路,一条通往“集成工具”,另一条通往“定制能力”,精准地服务于两种不同需求的开发者。

4.1 商业模式的进化:从API到订阅的战略拥抱

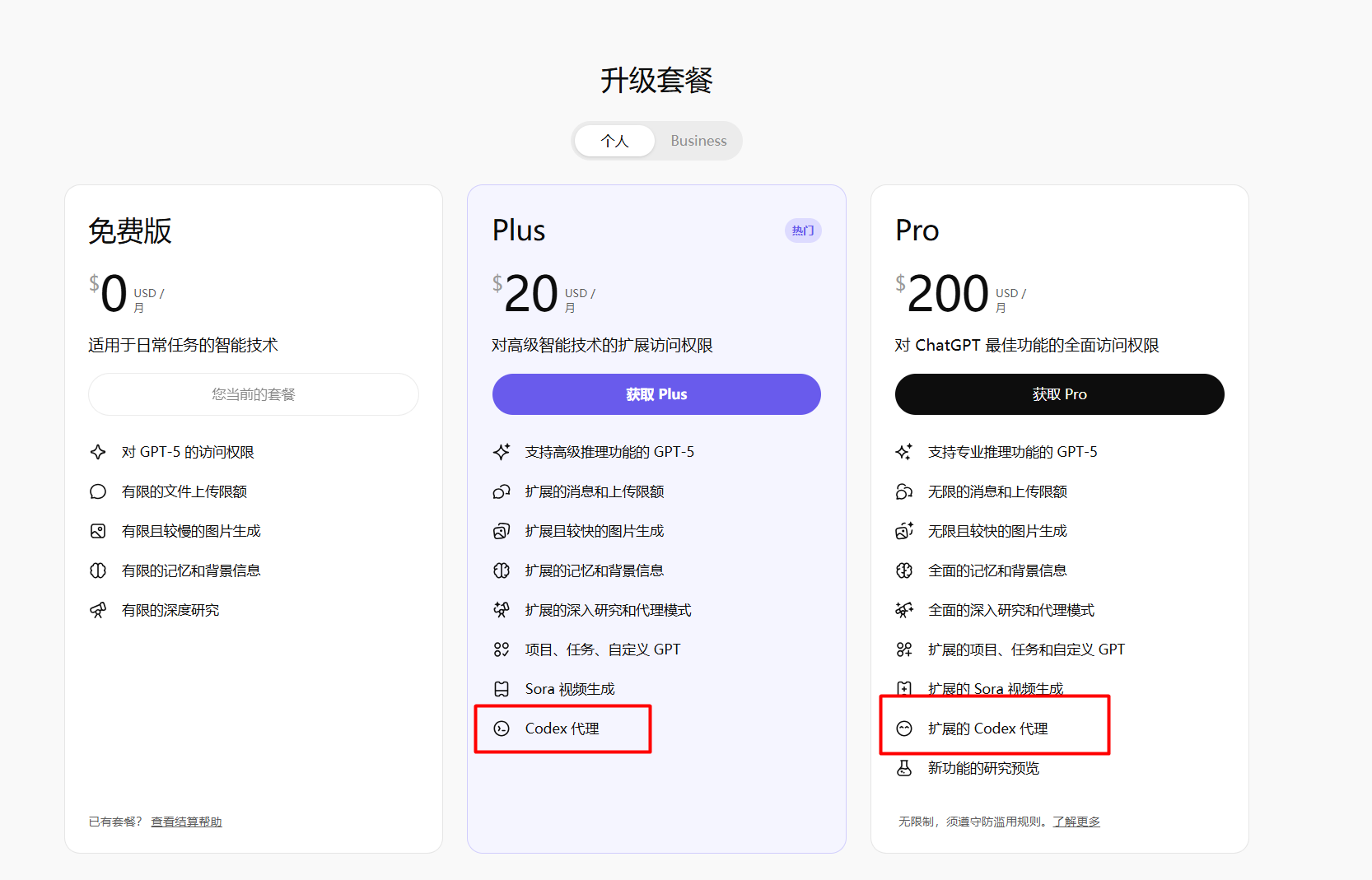

2025年的Codex,在商业模式上做出了一个根本性的转变。它不再像初代产品那样提供一个独立的API,而是将全部产品(Web、CLI、IDE)的访问权限,都深度整合进了ChatGPT的付费订阅计划中。

这意味着,无论是Plus、Pro还是企业版用户,你的ChatGPT会员卡,现在也是进入Codex世界的门票。

这是一个极其高明的商业决策。OpenAI不再与对手在单个工具上“掰手腕”,而是将Codex作为提升ChatGPT订阅含金量的“王牌”。你订阅的不再只是一个聊天机器人,而是一个涵盖了通用AI对话和专业开发者工具的“超级工作站”。这有效地将竞争从“按次计费”的API战场,转移到了“衡量综合价值”的生态系统高地,为自己挖下了一条深深的护城河。

4.2 使用额度详解:从入门到重度用户的阶梯

不同的订阅计划,对应着不同的使用配额。OpenAI对在本地运行的任务(CLI/IDE)和委托给云端的任务(Codex Web)也做了区分:

- Plus计划 ($20/月) :这是入门级。本地任务额度大约是每5小时30-150条消息,足够满足每周几次集中编码会话的需求。

- Pro计划 ($200/月) :专为职业开发者设计。本地任务额度飙升至每5小时300-1,500条消息,让你几乎可以全天候将Codex作为主力伙伴。

- Business/Team计划 ($25-$30/人/月) :基础额度与Plus相同,但团队可以购买额外的积分包,满足更高的使用需求。

- 云端任务:目前,所有付费计划的云端任务都处于一个“限时慷慨”的推广期,OpenAI正在大力鼓励用户体验其强大的代理功能。

需要注意的是,这里的“消息”是一个弹性单位,任务越复杂、代码库越大,消耗的资源就越多。这套分层体系,精准地覆盖了从轻度爱好者到硬核工程师的全部光谱。

4.3 API访问:为“构建者”保留的“超能力”接口

虽然产品本身转向了订阅,但OpenAI并未忘记那些希望将AI编码能力集成到自己应用中的“构建者”。为此,它保留了传统的、按使用量付费的API访问途径。

以下是2025年末核心编码模型的API定价(以每百万token计):

| 模型名称 | 输入成本 | 输出成本 | 核心场景 |

|---|---|---|---|

| gpt-5 | $1.25 | $10.00 | 旗舰性能,处理复杂代理任务,追求最高代码质量 |

| gpt-5-mini | $0.25 | $2.00 | 平衡之选,性能与成本兼顾 |

| gpt-5-nano | $0.05 | $0.40 | 极致性价比,适用于分类、摘要等低延迟、低成本任务 |

| codex-mini-latest | $1.50 | $6.00 | 专为编码优化,输入稍贵,输出便宜,适合“短指令、长代码”场景 |

市场洞察:用户与构建者的“双轨制”

OpenAI的策略清晰地将开发者分为了两类:

- 集成工具用户:他们想要的是开箱即用的效率工具,用来增强自己的日常工作流。对他们来说,订阅模式是最佳选择,支付月费,获得一整套“全家桶”服务。价值主张是便利。

- 定制应用构建者:他们想把AI编码能力作为一项功能,嵌入到自己的产品里。对他们来说,API模式至关重要,成本随用量弹性伸缩。价值主张是强大与灵活。

这种“双轨制”的市场细分,让OpenAI能够通吃从独立开发者到大型企业的整个市场,最大化了其技术的影响力。

第五部分:上手实战:手把手教你调用GPT-5 API (Python & Node.js)

理论讲完,让我们卷起袖子,亲自感受一下GPT-5 API的强大。本节将提供一份即刻可用的实践指南。

5.1 认证方式:分清“登录”与“密钥”

首先要明确,与OpenAI交互有两种认证方式:

-

使用Codex产品 (CLI/IDE):直接登录你的ChatGPT账户即可,简单方便。

获取OpenAI API Key编程调用API:必须使用API密钥。

-

获取api方案一:你需要去OpenAI开发者平台 (

platform.openai.com) 生成一个密钥。 -

获取api方案二:这条路适合国内开发者,特别是需要构建稳定、可扩展的生产级应用。在

uiuiAPI.com注册并获取GPT-5 API的秘钥。在UIUIAPI控制台的“令牌”部分生成你的专属API密钥,即可开始开发调用。

安全最佳实践:永远不要将API密钥硬编码在代码里! 最好的方法是将其存储在项目根目录下的 .env 文件中,并通过 dotenv 这样的库来加载。同时,把 .env 加入到你的 .gitignore 文件中,防止意外上传。

5.2 环境配置:两分钟准备就绪

Python环境:

# 安装官方库和dotenv

pip install openai python-dotenv然后创建一个 main.py 和一个 .env 文件。

Node.js环境:

# 初始化项目并安装依赖

npm init -y

npm install openai dotenv在 package.json 中加入 "type": "module" 以使用import语法。然后创建 index.js 和 .env 文件。

5.3 API请求的关键参数

向 /v1/chat/completions 端点发送请求时,这几个参数是你的“魔法棒”:

model: (必需) 指定模型,如"gpt-5"或"gpt-5-mini"。messages: (必需) 对话历史,一个包含role和content的对象数组。reasoning_effort: (GPT-5新增) 控制“思考深度”,可选值为"low","medium","high"。值越低,响应越快越便宜。verbosity: (GPT-5新增) 控制回答详尽度,可选值为"low","medium","high"。temperature: 控制创意的“火焰”,0.2表示严谨,0.8表示奔放。max_tokens: 限制输出长度,控制成本的“刹车”。

5.4 代码实战:你的第一个GPT-5调用

Python示例:生成一个递归阶乘函数

import os

from openai import OpenAI

from dotenv import load_dotenv

# 从.env文件加载环境变量

load_dotenv()

# 初始化OpenAI客户端

client = OpenAI(api_key=os.environ.get("OPENAI_API_KEY"))

client = OpenAI(api_key=os.environ.get("OPENAI_API_BASE"))#这里使用uiuiAPI key请填写uiuiAPI地址

try:

response = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "system", "content": "你是一个乐于助人的编程助手,擅长编写简洁高效的Python代码。"},

{"role": "user", "content": "请编写一个使用递归计算数字阶乘的Python函数。"}

],

temperature=0.7,

max_tokens=256,

reasoning_effort="medium", # GPT-5新增参数

verbosity="medium" # GPT-5新增参数

)

print(response.choices[0].message.content)

except Exception as e:

print(f"发生错误: {e}")Node.js示例:生成一个查找最长单词的JS函数

import OpenAI from 'openai';

import dotenv from 'dotenv';

// 加载环境变量

dotenv.config();

const openai = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

async function main() {

try {

const chatCompletion = await openai.chat.completions.create({

model: 'gpt-5',

messages: [

{ role: 'system', content: '你是一个乐于助人的编程助手,擅长编写优雅的JavaScript代码。' },

{ role: 'user', content: '请编写一个JavaScript函数,用于找出一个字符串中最长的单词。' }

],

temperature: 0.7,

max_tokens: 256,

reasoning_effort: 'medium', // GPT-5新增参数

verbosity: 'medium', // GPT-5新增参数

});

console.log(chatCompletion.choices[0].message.content);

} catch (error) {

console.error('发生错误:', error);

}

}

main();第六部分:群雄逐鹿:Codex在AI编码战场上的位置

OpenAI并非孤军奋战,AI编码的战场早已是巨头林立,高手如云。

6.1 Codex vs. Claude Code:短跑选手与架构师的对决

Anthropic的Claude Code,是Codex最直接的对手。它以其超大的上下文窗口和深刻的推理能力著称,更像一位“高级架构师”。当你需要进行复杂的跨文件重构,或者从零开始规划一个项目时,Claude倾向于先思考、再规划、后编码,产出的代码结构更优雅。

OpenAI的Codex,则在速度和性价比上更胜一筹,像一个“全能短跑选手”。在处理纯粹的算法实现或需要原始计算能力的任务时,Codex的代码往往更高效。一个在Claude上可能要花10美元的任务,用Codex可能只需3美元。

这是一场“架构师”与“短跑选手”的较量。Claude更适合深思熟虑的高风险任务,而Codex是更通用、更高效的日常开发伙伴。

6.2 环伺的巨头:Google Gemini与GitHub Copilot

- Google Gemini 2.5 Pro:它的杀手锏是百万级的上下文窗口和与Google全家桶(尤其是Android Studio)的深度集成。在需要分析整个代码库的“巨无霸”项目或安卓开发中,Gemini拥有主场优势。

- GitHub Copilot:它是一个特殊的存在。作为微软的“亲儿子”和OpenAI技术的最大分发渠道,Copilot既是盟友,也是“内部”的竞争者。它将OpenAI最先进的模型能力,无缝地带给了全球数千万开发者。

6.3 战略核心:生态的力量

面对强敌,OpenAI的核心战略是“不打单点,打生态”。

它没有选择在某个单一功能上与对手死磕,而是将Codex作为ChatGPT订阅的一部分。这一招“捆绑销售”极其高明,它迫使竞争对手陷入两难:要么也投入巨资构建自己的生态系统,要么就只能做一个细分领域的“小而美”工具。

一个开发者在选择时,很可能会倾向于一个编码能力90分,但同时打包了业界顶尖聊天、作图等多种AI工具的“瑞士军刀”,而不是为了那10分的差异,去为每个功能单独付费。这正是OpenAI希望看到的局面,也是其最深的护城河。

第七部分:硬币的另一面:正视风险、局限与Codex的星辰大海

技术的光芒背后,总有阴影。一个成熟的开发者,需要对工具的风险和局限有清醒的认识。

7.1 安全、版权与隐私:三道绕不开的坎

- 安全风险:模型在训练时“吃”进去了大量开源代码,也可能“学会”了其中的不安全写法。研究表明,AI生成的代码中约有40%可能包含漏洞。记住:AI写的每一行代码,都必须经过人类的严格审查和充分测试。

- 版权问题:这是一个法律灰色地带。在极少数情况下,模型可能会原封不动地“吐出”训练数据中的代码片段,带来潜在的IP风险。

- 数据隐私:对于企业和API用户,OpenAI承诺不使用其数据进行训练。但对于个人订阅用户,你的对话内容可能会被用于模型改进,除非你手动选择退出(opt-out)。这一点,对于处理敏感代码的开发者来说至关重要。

7.2 已知局限:它不是万能的“神谕”

Codex远非完美。它生成的代码有时效率不高,有时会偏离你的真实意图。在面对需要多步复杂逻辑推理的问题时,它仍然会“犯傻”。此外,作为一个云服务,它偶尔也会有延迟升高或服务中断的小脾气。

这些局限提醒我们,现阶段的AI助手,是一个能力超强但会犯错的“实习生”,而不是一个全知全能的“大神”。人类的监督、判断和最终拍板,仍然是软件开发中不可或缺的核心。

7.3 Codex的未来:通往“虚拟软件工程师”的宏伟蓝图

展望未来,OpenAI的野心清晰而宏大:将Codex打造成一个真正的“虚拟软件工程师团队成员”。

未来的路线图聚焦于:

- 更强的自主性:让AI能独立完成需要数天才能完成的复杂任务。

- 企业级定制:允许企业用私有代码库来“喂养”和微调Codex,让它成为理解你公司业务的内部专家。

- 更强的交互性:开发者可以在任务执行中途进行指导和干预,实现真正的人机协同。

- 最终愿景:实现一种“大规模并行”的开发模式。一个人类工程师,指挥一个由AI代理组成的“军团”,以前所未有的速度和规模构建软件系统。

这不仅仅是工具的进化,这是一场对软件创造方式的根本性重塑。

界智通(jieagi)结论:从代码“码农”到AI“指挥家”

Codex从一个代码补全工具到自主代理平台的演变,为我们清晰地描绘了AI时代软件开发的未来图景。这不仅仅是工具的更迭,更是一场深刻的角色转变:开发者正从代码的直接创作者,转变为高阶任务的委托者和AI代理的管理者。

由GPT-5驱动,Codex通过其多组件的协同生态,为我们提供了一个前所未有的集成化工作环境,并用巧妙的商业策略构筑了坚固的壁垒。它为开发者提供了两条清晰的道路:通过订阅拥抱便利的生产力工具,或通过API驾驭强大的底层能力去创造未来。

然而,前路光明,挑战犹存。安全、版权、隐私的风险,以及“基准性能”与“真实生产力”之间的鸿沟,都提醒我们,将AI高效、无缝地融入高质量的工程实践,依然是一条需要不断探索的道路。

总而言之,OpenAI Codex和GPT-5共同掀开了软件开发的新篇章。未来,衡量一个优秀工程师的标准,或许将不再仅仅是他能写出多漂亮的代码,更在于他能多高效地驾驭和指挥这些日益强大的AI代理,去实现那些曾经遥不可及的创新。

版权信息: 本文由 界智通(jieagi) 团队编写,保留所有权利。未经授权,不得转载或用于商业用途。

本文发布于2025年09月11日21:36,已经过了145天,若内容或图片失效,请留言反馈 转载请注明出处: 界智通

本文的链接地址: https://www.jieagi.com/aizixun/79.html

-

2025最新:Claude Pro 与 Max 区别详解与订阅指南

2025/08/26

-

Cursor权威指南:从注册入门到精通AI驱动编程工作流(含国内注册与验证说明)

2025/08/27

-

Gemini 报错 "Something went wrong" 终极解决指南

2025/11/27

-

GPT-5-Codex保姆级教程:获取OpenAI APIKey与安装 Codex CLI使用教程全面指南

2025/09/17

-

【实测有效】Gemini 3 / Google Antigravity 授权登录无反应、无权限?全平台解决办法汇总指南

2025/11/22

-

2025最新保姆级教程:如何获取Claude API Key?从注册到Python调用,一篇搞定!

还在为如何申请 Claude API Key 而头秃吗?随着 Claude 4.5 Sonnet 在编程能力上的强势崛起,越来越多的开发者开始转向 Anthropic 的阵营。本文将通过“保姆级”的图文实操,带你一步步解决账号注册、手机号验证、API Key 获取及额度充值等难题,并附带 Python 极简调用示例。无论你是想接入 LangChain 还是自己在这个强大的模型上跑 Demo,这篇文章都能帮你避开 99% 的坑!

2025/11/15

-

OpenAI GPT-5 深度解析:API Key定价与ChatGPT(Free, Plus, Pro)用户的区别

2025/08/08

-

OpenAI GPT-5 定价与功能对比:API Key 与 ChatGPT 各版本全解析

2025/08/10

-

深度解析 Gemini 2.5 Flash Image Preview:API Key 获取、核心能力与多模态调用实践

2025/09/09

-

Claude订阅避坑指南:Pro还是Max?看完这篇再决定!

2025/08/26

暂无评论

界智通

界智通  jieagi_Pan

jieagi_Pan

太好看了,快点更新!

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略

这是系统生成的演示评论

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略