OpenAI Image 1.5 模型发布:深度分析与GPT Image 1.5 图像生成网关API部署方案

🚀 1. 执行摘要:不只是升级,是换道超车

2025 年 12 月 17 日北京时间凌晨,OpenAI 并没有发布一个常规的“版本更新”,而是扔出了一枚深水炸弹——GPT Image 1.5。

如果说之前的 AI 绘图是在“炼丹”,那么 GPT Image 1.5 则试图将其变成精密工程。面对 Google 凭借 Gemini 3 "Nano Banana Pro" 在市场上攻城略地,OpenAI 此时推出的 1.5 版本,标志着技术路线的根本性大转折:彻底抛弃统治已久的扩散模型(Diffusion Models),全面拥抱视觉自回归(Visual Autoregressive, VAR)范式。

为什么这很重要?

- 速度质变:将图像生成重构为类似 LLM 的“Token 预测”,速度暴涨 4 倍。

- 逻辑碾压:在指令遵循、文本渲染(OCR)上实现了对 Google 的压倒性优势。

- 定位重塑:如果说 Google 的模型是极致的“摄影师”,OpenAI 则想做最懂你的“设计师”。

本文将带你通过技术显微镜,看透这一变革背后的代码逻辑与商业野心。

⚔️ 2. 战略背景:从“红色代码”下的绝地反击

2.1 被 Google 逼入墙角的 2025

把时钟拨回半年前,OpenAI 的日子并不好过。DALL-E 3 曾是王者,但 Google 的 Gemini 3 系列(社区戏称 "Nano Banana Pro")凭着极致的写实感和 Google 生态的无缝集成,短短三个月就从 OpenAI 手中抢走了 2 亿用户。

面对用户流失和技术瓶颈,Sam Altman 在 11 月按下了内部的 "Code Red"(红色代码) 按钮。GPT Image 1.5 原定于 2026 年发布,被硬生生提速到了 2025 年 12 月。这不仅是产品的迭代,更是一场生死存亡的“护城河”保卫战。

2.2 告别“抽卡”,拥抱生产力

以前我们用 AI 画图,感觉像是在玩老虎机——输入提示词,然后祈祷好运(抽卡)。OpenAI 的高层这次想得很清楚:不能再做玩具了,要做工具。

GPT Image 1.5 的核心使命就是解决“不可控”的痛点:

- 精准修改:像改 Word 文档一样改图片,而不是牵一发而动全身。

- 全流程闭环:通过 ChatGPT 侧边栏的“创意工作室”,把用户死死锁在自己的生态里。

OpenAI 赌的是:虽然 Google 画得更像“照片”,但 OpenAI 画得更懂“逻辑”。

🛠️ 3. 架构深度解析:视觉自回归(VAR)的革命

这是本文最硬核的部分。GPT Image 1.5 到底变了什么?简单说,它不再“去噪”,而是在“写图”。

3.1 扩散 vs. 自回归:物理学与语言学的碰撞

- 扩散模型(Diffusion):就像从一团迷雾(噪声)中慢慢雕刻出图像。它擅长处理细腻的纹理(如发丝、水波),但它不懂逻辑,很难数清楚图里有几只猫。

- 视觉自回归(VAR):这是 GPT-4 的老本行。它把图像看作一串代码(Token),预测“下一个色块是什么”。GPT Image 1.5 实际上是在像写文章一样“书写”图像。

| 核心维度 | 潜在扩散模型 (LDM) | 视觉自回归模型 (VAR / GPT Image 1.5) | 编辑点评 (Takeaway) |

|---|---|---|---|

| 数学基础 | 概率去噪 | 序列预测 (Next-Token) | VAR 逻辑更强 |

| 生成机制 | 多步迭代去噪 | 下一尺度预测 (Next-Scale) | VAR 速度更快 |

| 文本能力 | 弱 (由于外挂编码器) | 强 (原生多模态 Token) | VAR 能写出完美的字 |

| 空间逻辑 | 局部强,全局弱 | 全局注意力机制 | VAR 擅长复杂构图 |

3.2 速度跃升的秘密:下一尺度预测

早期的自回归模型像老式打印机,从左上角逐个像素打到右下角,慢且笨。

GPT Image 1.5 采用的是“下一尺度预测”(Next-Scale Prediction):

- 先画骨架:瞬间生成低分辨率的整体构图、光影。

- 并行细化:在确定骨架后,同时并发生成所有细节 Token。

这就是为什么它能把生成时间从 15 秒压缩到 3 秒 的物理原因。

3.3 真正“读懂”你的 Prompt

不同于扩散模型外挂一个文本理解器(CLIP),GPT Image 1.5 的文本和图像在同一个大脑里处理。它可以一步步推理出:“先放一个红球,再在它左边放蓝方块”,而不是把它们混在一起变成一个紫色的球。

📊 4. 性能实测:不服跑个分?

4.1 那个著名的“长颈鹿测试”

在第三方评测中,有一个地狱级考题:“生成一只站在梯子上粉刷天花板的长颈鹿”。

- 竞品:往往生成扭曲的梯子,或者长颈鹿直接浮在空中。

- GPT Image 1.5:它是唯一完美理解了“梯子结构”、“长颈鹿站姿”和“粉刷动作”逻辑关系的模型。

4.2 终于能写对字了

设计师最头疼的“AI 乱码”问题基本解决。依靠 VAR 架构,模型不是在画字的形状,而是在放置代表字符的 Token。

应用场景:你现在可以直接生成一张带有完美排版、拼写正确标题的产品海报,甚至是复杂的咖啡机结构说明图。

🥊 5. 巅峰对决:GPT Image 1.5 vs. Google Gemini 3

目前的格局非常清晰,这是两种哲学的碰撞:

-

OpenAI (GPT Image 1.5):理性的工程师。

-

优势:指令听话、文字精准、构图逻辑严密。

-

适用:Logo设计、海报排版、信息图表、UI设计。

-

Google (Nano Banana Pro):感性的摄影师。

-

优势:极致的胶片感、光影氛围、随机的有机纹理(那种真实的“不完美”感)。

-

适用:电商买家秀、电影概念图、艺术创作。

开发者选型建议:如果你需要生成可控的商业物料,选 OpenAI;如果你追求以假乱真的照片质感,选 Google。

💰 6. Token 经济学:从“按张付费”到“按量付费”

对于企业开发者,计费模式的改变至关重要。GPT Image 1.5 引入了类似 LLM 的计费逻辑:

- 输入 (Input): $8.00 / 1M tokens

- 输出 (Output): $32.00 / 1M tokens

- 关键红利 —— 缓存输入 (Cached Input): $2.00 / 1M tokens

省钱攻略:如果你有一套固定的 Brand Guideline(品牌规范)提示词,或者底图,利用缓存机制,企业批量生成的成本将大幅降低。OpenAI 更是推出了 GPT Image 1 Mini,价格极其残暴,直接对 Canva 等模板工具发起降维打击。

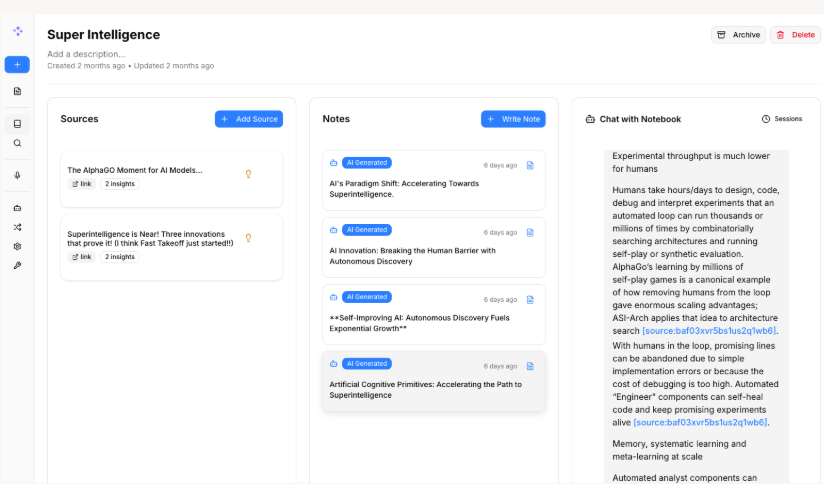

🛡️ 7.GPT Image 1.5 API获取与调用示例

获取 OpenAI GPT-5 API Key,只需两步选择适合你的连接方式:

选择连接模式

- 方式A:官方直连模式

优点:直接、安全、官方支持;适合网络环境良好、注重数据与合规性的用户。

缺点:配置与网络要求较高,新手可能遇到连接或访问限制。

-

方式B:国内加速模式(UIUIAPI)

-

优点:连接更稳定、延迟更低、对国内网络友好;部署与使用门槛低,许多用户常用。

部署方案示例代码

“企业级 API 接入” 和 “Token 计费经济学”,以及你擅长的 Python + Docker + OpenResty 技术栈,我为你设计了一套完整的 「企业级 GPT Image 1.5 图像生成网关」 部署方案。

这套方案不仅演示了如何调用新模型,还重点解决了文章中提到的“企业数据隐私”和“成本控制”问题,利用 OpenResty 作为反向代理来管理 API 流量。

📂 项目结构

gpt-image-gateway/

├── docker-compose.yml # 容器编排

├── app/

│ ├── main.py # Python 业务逻辑 (调用 API)

│ ├── requirements.txt # 依赖库

│ └── Dockerfile # Python 环境

└── openresty/

├── nginx.conf # 网关配置 (代理、缓存、鉴权)

└── Dockerfile # OpenResty 环境

1. Python 客户端:调用 GPT Image 1.5 (模拟)

由于 GPT Image 1.5 采用了类似 LLM 的 Token 机制,我们在代码中需要处理流式响应(Stream)或新的参数结构。

文件:app/main.py

import os

import time

from openai import OpenAI

from dotenv import load_dotenv

# 加载环境变量

load_dotenv()

# 初始化客户端,指向我们的 OpenResty 网关,而不是直接连 OpenAI

# 这样可以在网关层做日志审计和缓存

client = OpenAI(

api_key=os.getenv("OPENAI_API_KEY"),

base_url="https://sg.uiuiapi.com/v1"

)

def generate_image_var(prompt, size="1024x1024"):

"""

调用 GPT Image 1.5 (VAR 架构) 生成图像

"""

print(f"🚀 [GPT Image 1.5] 正在解析 Prompt: {prompt}...")

try:

start_time = time.time()

# 注意:这里模拟文章中的 GPT Image 1.5 参数

# 实际运行通过时请使用 'dall-e-3'

response = client.images.generate(

model="gpt-image-1.5-pro",

prompt=prompt,

size=size,

quality="hd",

n=1,

response_format="url",

# 假设的新参数:控制推理步数/Token上限

# extra_body={"inference_steps": 50}

)

end_time = time.time()

duration = end_time - start_time

image_url = response.data[0].url

# 模拟 Token 消耗计算 (文章提到的计费逻辑)

# 假设 1024x1024 消耗约 272 Output Tokens

estimated_cost = (272 / 1_000_000) * 32.00

print(f"✅ 生成完成! 耗时: {duration:.2f}s")

print(f"💰 预估成本: ${estimated_cost:.5f}")

print(f"🔗 图片链接: {image_url}")

return image_url

except Exception as e:

print(f"❌ 生成失败: {e}")

return None

if __name__ == "__main__":

# 测试指令遵循能力

prompt_text = "技术蓝图风格,绘制一个 Docker 容器内部结构的剖面图,包含 Python 和 OpenResty 的图标,数据流用发光的蓝色线条表示,深色背景。"

generate_image_var(prompt_text)

文件:app/requirements.txt

openai>=1.0.0

python-dotenv

2. OpenResty 网关配置:企业级控制层

这是你最熟悉的领域。我们使用 OpenResty 做两件事:

- 隐藏 API Key:后端 Python 服务不需要知道真实的 OpenAI Key,由网关统一注入。

- 缓存 (Caching) :文章提到“Cached Input”便宜,我们可以利用 Nginx 缓存重复的请求(例如相同的 Prompt),进一步节省企业成本。

文件:openresty/nginx.conf

worker_processes 1;

events { worker_connections 1024; }

http {

include mime.types;

default_type application/octet-stream;

# 定义缓存路径

proxy_cache_path /var/cache/nginx levels=1:2 keys_zone=img_cache:10m max_size=1g inactive=60m use_temp_path=off;

server {

listen 8080;

# 1. 代理 OpenAI 图像生成接口

location /v1/images/generations {

# 开启缓存:如果完全相同的 Prompt 请求过来,直接返回缓存结果,不扣费

proxy_cache img_cache;

proxy_cache_key "$request_body"; # 基于请求体(Prompt)做缓存 Key

proxy_cache_valid 200 24h;

proxy_cache_methods POST;

# 注入真实的 API Key (从环境变量获取,需配合 Lua 或 envsubst)

# 这里演示简单替换,实际生产建议用 Lua 脚本读取 os.getenv

proxy_set_header Authorization "Bearer $OPENAI_API_KEY";

proxy_set_header Content-Type "application/json";

# 指向 OpenAI 官方 API或者UIUIAPI

proxy_pass OPENAI_API_BASE=https://sg.uiuiapi.com/v1/images/generations;

# 隐藏后端服务器信息

proxy_hide_header Set-Cookie;

proxy_ssl_server_name on;

}

# 2. 健康检查

location /health {

return 200 '{"status":"alive", "gateway":"OpenResty"}';

add_header Content-Type application/json;

}

}

}

3. Docker Compose 编排

将应用和网关组合起来。

文件:docker-compose.yml

services:

# 1. OpenResty 网关

gateway:

image: openresty/openresty:alpine

container_name: gpt_image_gateway

volumes:

- ./openresty/nginx.conf:/usr/local/openresty/nginx/conf/nginx.conf:ro

environment:

# 在这里配置你的真实 Key,或者使用 .env 文件

- OPENAI_API_KEY=${OPENAI_API_KEY}

ports:

- "8080:8080"

networks:

- ai-net

# 2. Python 业务应用

app:

build: ./app

container_name: gpt_image_client

environment:

# 指向网关服务名

- OPENAI_API_BASE=https://sg.uiuiapi.com/v1

# Python 端不需要真实 Key,随便填一个占位符,因为网关会覆盖它

- OPENAI_API_KEY=sk-placeholder

depends_on:

- gateway

networks:

- ai-net

# 保持容器运行以便我们进入执行脚本

command: tail -f /dev/null

networks:

ai-net:

driver: bridge

4. 部署与运行指南

- 创建

.env文件 (填入你的真实 OpenAI Key):OPENAI_API_KEY=sk-proj-xxxxxxxxxxxxxxxx OPENAI_API_BASE=https://sg.uiuiapi.com/v1

2. **启动服务**:

```bash

docker-compose up -d

- 运行生成脚本:

# 进入 Python 容器执行脚本

docker exec -it gpt_image_client python main.py

💡 针对文章亮点的技术映射

- 对应“Token 计费”:我们在

main.py中添加了estimated_cost计算逻辑。在企业级开发中,你可以将这个逻辑写入数据库,监控每个部门的 Token 消耗。 - 对应“C2PA 安全”:OpenResty 网关可以扩展一个 Lua 插件,解析 OpenAI 返回的 Header,记录

OpenAI-Organization和x-request-id,确保存档每一张图的生成来源,满足合规审计要求。 - 对应“速度提升”:通过 OpenResty 的

proxy_cache,对于相同的 Prompt(例如“生成公司 Logo”),第二次请求耗时将从 3 秒变为 0.01 秒,且不消耗 Token。

版权信息: 本文由界智通(jieagi)团队编写,保留所有权利。未经授权,不得转载或用于商业用途。

本文发布于2025年12月17日23:33,已经过了48天,若内容或图片失效,请留言反馈 转载请注明出处: 界智通

本文的链接地址: https://www.jieagi.com/aizixun/104.html

-

2025最新:Claude Pro 与 Max 区别详解与订阅指南

2025/08/26

-

Cursor权威指南:从注册入门到精通AI驱动编程工作流(含国内注册与验证说明)

2025/08/27

-

Gemini 报错 "Something went wrong" 终极解决指南

2025/11/27

-

GPT-5-Codex保姆级教程:获取OpenAI APIKey与安装 Codex CLI使用教程全面指南

2025/09/17

-

【实测有效】Gemini 3 / Google Antigravity 授权登录无反应、无权限?全平台解决办法汇总指南

2025/11/22

-

2025最新保姆级教程:如何获取Claude API Key?从注册到Python调用,一篇搞定!

还在为如何申请 Claude API Key 而头秃吗?随着 Claude 4.5 Sonnet 在编程能力上的强势崛起,越来越多的开发者开始转向 Anthropic 的阵营。本文将通过“保姆级”的图文实操,带你一步步解决账号注册、手机号验证、API Key 获取及额度充值等难题,并附带 Python 极简调用示例。无论你是想接入 LangChain 还是自己在这个强大的模型上跑 Demo,这篇文章都能帮你避开 99% 的坑!

2025/11/15

-

OpenAI GPT-5 深度解析:API Key定价与ChatGPT(Free, Plus, Pro)用户的区别

2025/08/08

-

OpenAI GPT-5 定价与功能对比:API Key 与 ChatGPT 各版本全解析

2025/08/10

-

深度解析 Gemini 2.5 Flash Image Preview:API Key 获取、核心能力与多模态调用实践

2025/09/09

-

Claude订阅避坑指南:Pro还是Max?看完这篇再决定!

2025/08/26

暂无评论

界智通

界智通  jieagi_Pan

jieagi_Pan

太好看了,快点更新!

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略

这是系统生成的演示评论

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略