VS Code 里的 AI 进化论:为什么 Roo Code 可能是比 Cursor 更适合你的“编程搭子”?(深度解析 + API配置)

【摘要】 当 GitHub Copilot 还在做“完形填空”时,真正的 AI Agent 已经开始帮我们写整个模块了。本文深度解析开源界的新星——Roo Code(原 Roo Cline)。作为一款 AI 原生 的 VS Code 插件,它凭借MCP 协议集成、影子 Git 安全网以及完全开源的 BYOK(自带 Key)模式,正迅速成为高级开发者的心头好。本文将从架构设计、Token 经济学、实战配置到与 Cursor/Cline 的全方位对比,带你通过 Roo Code 掌握下一代“人机协作”的开发流。无论你是想用 DeepSeek 搭建本地私有化编程助手,还是追求 Claude 3.5 Sonnet 的极致编程体验,这篇文章都能给你答案。

前言:除了 Copilot,我们还能期待什么?

作为一名在这个行业摸爬滚打多年的开发者,你是否感觉到 IDE 的进化似乎到了一个瓶颈?

过去的十年,我们见证了从“记事本”到“智能感知(IntelliSense)”,再到 GitHub Copilot 的“智能补全”。但说实话,现在的 AI 编程助手大多还停留在“副驾驶”的位置——你需要盯着它,光标移到哪,它补到哪。

如果 AI 不再只是“补全代码”,而是像一个真正的初级工程师那样,能理解你的需求、自己规划任务、跑测试、修 Bug 呢?

这就是我们将要讨论的主角:Roo Code。它代表了软件工程的第四阶段——自主智能代理(Autonomous Agents)。在这个阶段,VS Code 不再只是编辑器,它变成了一个容纳“AI 开发团队”的作战室。

一、 Roo Code 是谁?为什么要关注它?

简单来说,Roo Code 是开源项目 Cline 的一个“激进派”分支(Fork)。

如果说 Cline 是追求稳健的企业级选手,那么 Roo Code 就是那个酷爱尝试新技术的“极客”。它由 Roo Veterinary Inc. 维护,主打 Bleeding Edge(前沿技术) 策略。

- 想用最新的 DeepSeek R1 或 Claude 4.5 Sonnet?Roo Code 通常是第一时间支持的。

- 想体验 Anthropic 最新的 MCP(模型上下文协议)?Roo Code 集成得最深。

它适合那些不满足于“黑盒”服务,想要极致控制力和数据主权的高级工程师。

二、 核心解构:它如何像人类一样工作?

Roo Code 之所以能被称为 Agent,是因为它具备了“感知-规划-行动”的完整闭环。让我们拆解一下它的“大脑”。

2.1 感知层:不仅要“读”得多,还要“读”得准

在长上下文(Long Context)时代,丢给 AI 一堆文件只会让它“幻觉”频出。Roo Code 采用了一套精细的 Token 经济学:

-

精准投喂(Context Mentions):

别把整个项目都塞进 Context Window。在 Roo Code 里,你可以像在群聊里 @同事 一样 @资源: -

@/path/to/file:只看这个文件。 -

@git-changes:神器! 只让 AI 关注你刚改动但没提交的代码(Code Review 必备)。 -

@terminal:直接把报错堆栈喂给 AI,不用复制粘贴。 -

钱包守护者:

这可能是我最喜欢的功能。Roo Code 会实时显示 Input/Output Token 和预估花费的美元。它在教你写代码的同时,也在训练你写出更省钱的 Prompt。

2.2 决策层:带上不同的“帽子”

Roo Code 引入了 “模式(Modes)” 的概念。这就像是你雇佣了不同的专家:

| 模式名称 | 角色设定 | 适用场景 | 核心逻辑 |

|---|---|---|---|

| Architect Mode | 架构师 | 系统设计、技术选型 | 只读权限,拥有全局视野,擅长权衡利弊,禁止乱改代码。 |

| Code Mode | 工程师 | 功能开发、Bug 修复 | 读写权限,强调代码准确性与 Lint 规则遵循。 |

| Debug Mode | 侦探 | 复杂报错排查 | 擅长分析日志,提出假设并验证(Loop 循环)。 |

| Ask Mode | 导师 | 代码库理解 | 只读权限,负责解释代码和回答疑问。 |

💡 编辑建议:你可以利用这个特性,先用 DeepSeek R1(推理能力强)在“架构师模式”下制定方案,然后切换到 Claude 3.5 Sonnet(编码速度快)在“代码模式”下执行。这就是 AI 时代的“田忌赛马”。

2.3 执行层与安全网:放手,但别放纵

Roo Code 能直接运行 npm install,能修改文件,甚至能通过 Puppeteer 操作浏览器。但这听起来是不是有点可怕?万一 AI 删库怎么办?

Roo Code 设了两道防线:

- 影子 Git 仓库(Shadow Git Repository):

这是它的杀手锏。Roo Code 会在后台默默维护一个独立的 Git 快照。无论 AI 把代码改得多么面目全非,你都可以通过“检查点(Checkpoints)”一键回滚。它不会污染你真正的主分支 Git 记录。 - 权限门控:

默认情况下,任何写入操作和高危命令都需要你点击“批准”。当你信任它后,可以设置“自动批准”,比如“允许自动读取文件,但写入必须确认”。

三、 MCP 协议:给 AI 装上“三头六臂”

Model Context Protocol (MCP) 是 Anthropic 推出的一项大杀器,Roo Code 是目前支持最好的客户端。

以前,AI 只能看你编辑器里的代码。有了 MCP,AI 可以连接万物:

- 连接数据库:安装 PostgreSQL MCP,AI 就能直接查表结构,帮你写出 100% 正确的 SQL。

- 连接文档:安装 Docs MCP,当你在用最新的 Next.js 版本时,AI 可以实时去官网查文档,不再受限于训练数据的滞后。

- 连接 Linear/Jira:AI 可以直接读取你的任务票据,写完代码后自动更新任务状态。

实战场景:

你告诉 Roo Code:“帮我修一下登录 Bug。”

它可以:调用 Linear MCP 读 Bug 描述 -> 调用 Postgres MCP 查用户表 -> 修改代码 -> 调用 Playwright MCP 启动浏览器自动测试登录。

这就是从“写代码”到“解决问题”的质变。

四、 丰俭由人:BYOK 与本地化模型

Roo Code 坚持 BYOK (Bring Your Own Key) 策略,这意味着你拥有完全的选择权。

4.1 追求极致体验(土豪/公司报销版)

直接接入 Claude 4.5 Sonnet 或 GPT-5.2。这是目前编程体验的天花板,虽然通过 API 付费可能比订阅 Copilot 贵,但效率提升是肉眼可见的。

4.2 追求隐私与免费(极客/保密版)

通过 Ollama 接入本地模型。

- 安装 Ollama:

ollama run qwen2.5-coder - 在 Roo Code 设置里填入

http://localhost:11434 - Result:代码不出内网,费用为零。随着 DeepSeek-Coder-V2 等开源模型的崛起,本地体验已经越来越接近云端了。

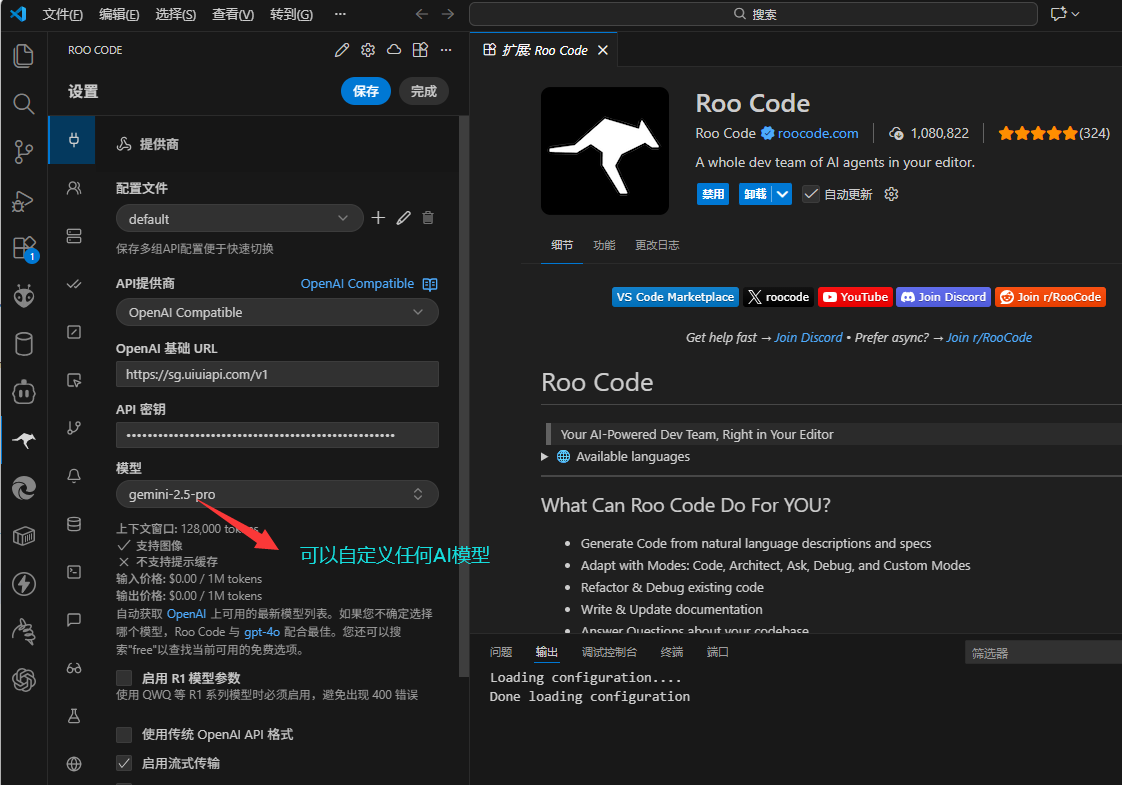

4.3 国内开发者以及自定义(便捷/自定义)

通过 OpenAI Compatible 协议来使用第三方中转服务(sg.uiuiapi.com)提供的 Gemini 模型。

以下是详细的配置解读和步骤:

1. 选择 API 提供商 (API Provider)

- 设置项:

API提供商/API Provider - 选择: OpenAI Compatible

- 原因:

sg.uiuiapi.com是一个 API 中转/聚合平台,它将各种模型(Google Gemini, Claude, GPT)统一封装成了 OpenAI 的接口格式。因此,不要选择列表里的 "Google Gemini",必须选 "OpenAI Compatible"。

2. 填写 Base URL (基础链接)

- 设置项:

OpenAI 基础 URL - 填写:

https://sg.uiuiapi.com/v1 - 注意: 这里的

/v1后缀通常是必须的,这是 OpenAI 接口规范的标准路径。

3. 填写 API 密钥 (API Key)

- 设置项:

API 密钥 - 填写:

sk-xxxxxxxx...(你在 uiuiapi 平台后台生成的令牌) - 安全提示: 不要将此 Key 泄露给他人。

4. 配置模型 ID (Model ID)

- 设置项:

模型 - 填写:

gemini-2.5-pro(根据你的截图) - 关键说明:

- 关于

gemini-2.5-pro: Google 官方目前的最新版本是 Gemini 3.0 Pro / Flash。gemini-2.5-pro很可能是该中转服务商(UiUiAPI)自定义的一个模型映射名称,或者是指向了特定版本的 Gemini。 - 如何确认: 如果这个模型无法工作,请去

uiuiapi.com的后台“模型列表”中查看他们支持的确切模型 ID,通常可能是gemini-3.0-pro或gpt-5.2等。

5. 其他重要参数

- 上下文窗口 (Context Window): 图中显示为

128,000。这决定了 AI 能一次性“记住”多少代码。Gemini 2.5 Pro 实际支持更大(如 1M 或 2M),但在中转商处通常会有限制,128k 是一个安全且足够大的数值。 - 启用流式传输 (Stream Output): 勾选。这样 AI 回复时会像打字机一样一个个字蹦出来,而不需要等全部生成完才显示,体验更好。

4.4:使用建议

-

费用监控: 使用中转 API 需要关注你在

uiuiapi的余额。Roo Code 会消耗大量的 Token,因为它会将很多上下文(文件内容)发送给 AI。 -

自定义指令 (Custom Instructions):

- Roo Code 允许你设置“自定义指令”。建议你在那里添加:“请始终使用中文回答”、“代码注释请使用中文”等要求,以便更符合你的使用习惯。

-

模式切换:

- 如果发现

gemini-2.5-pro编程能力不够强(有时 Gemini 容易产生幻觉),你可以在下方的“模型”下拉菜单中随时手动输入其他模型 ID(例如claude-sonnet-4-5-20250929),服务商是支持该模型。

- 如果发现

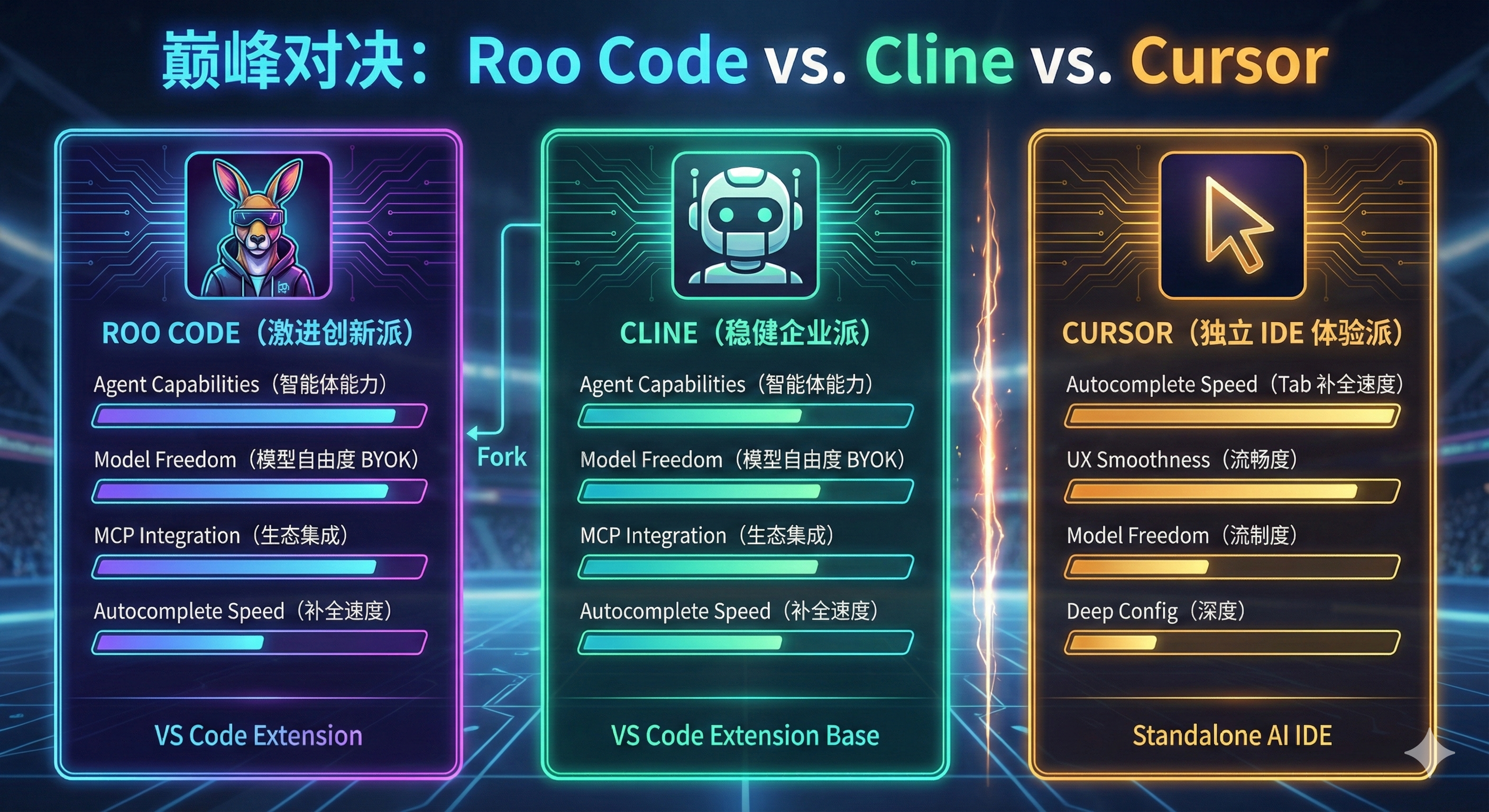

五、 巅峰对决:Roo Code vs. Cline vs. Cursor

这是大家最关心的问题。既然有了 Cursor,我为什么要折腾 Roo Code?

| 维度 | Roo Code | Cline | Cursor |

|---|---|---|---|

| 本质 | VS Code 插件 (Fork 自 Cline) | VS Code 插件 | 独立 IDE (魔改自 VS Code) |

| 核心哲学 | 掌控一切:激进创新、高可配置 | 稳健:企业合规、开箱即用 | 流畅:极致体验、闭环生态 |

| 代码补全 | 较弱(主要靠 Agent 对话) | 较弱 | 极强 (Copilot++ Tab补全无人能敌) |

| Agent 能力 | 极强 (MCP, 影子Git, 多模式) | 强 | 较强 (主要依赖内置功能) |

| 模型自由度 | ⭐⭐⭐⭐⭐ (任意 API + 本地) | ⭐⭐⭐⭐ | ⭐⭐⭐ (限制较多) |

| 适用人群 | 架构师、全栈、本地模型党 | 企业团队、求稳开发者 | 追求极致手感、不愿折腾配置的用户 |

结论很简单:

- 如果你想要最丝滑的 Tab 代码预测,选 Cursor。

- 如果你想要一个能独立完成复杂任务、能连接本地模型、且完全免费开源(只需付 API 费)的 AI 员工,Roo Code 是不二之选。

- 终极玩法:使用 Cursor 作为编辑器(享受 Tab 补全),同时安装 Roo Code 插件(处理复杂 Agent 任务)。双剑合璧,天下无敌。

六、 结语:拥抱 AI 原生开发

Roo Code 不仅仅是一个工具,它预示着未来 IDE 的样子——IDE 不再只是文本编辑器,它是人类意图与 AI 执行力之间的“编排层”。

虽然 Roo Code 的配置门槛稍高,Token 消耗也需要关注,但它给予你的自由度和掌控感是无与伦比的。在这个 AI 快速迭代的时代,与其被动等待大厂投喂功能,不如掌握 Roo Code 这样的利器,构建属于你自己的 AI 开发流。

版权信息: 本文由界智通(jieagi)团队编写,保留所有权利。未经授权,不得转载或用于商业用途。

本文发布于2025年12月17日20:15,已经过了48天,若内容或图片失效,请留言反馈 转载请注明出处: 界智通

本文的链接地址: https://www.jieagi.com/aigongju/103.html

-

从零到高手:Mac安装Claude Code CLI全攻略,让AI成为你的编程搭档

嘿,兄弟姐妹们!作为一名在代码海洋里摸爬滚打多年的老鸟,我知道你们总在为调试代码、脑洞创意抓狂。想象一下,有个AI助手像忠实伙伴一样,随时帮你生成代码、解释难题——这就是Claude Code CLI的魅力!它能让你的编程效率像火箭一样飙升。今天,我手把手带你安装配置,确保你零门槛上手。走起,别让AI的魔法溜走! 先检查你的“装备”:安装前提 别急着冲,先确...

2025/07/21

-

Cursor - AI编程工具接入uiuiAPI聚合平台图文教程

(1) Cursor简要 Cursor 是一类以大语言模型(LLM)为核心、面向开发者的交互式编码 IDE/助理工具。它把自然语言对话、代码理解、即时运行与编辑器/终端集成在一起,帮助开发者更快地阅读、生成、重构、调试代码与编写测试等。 (2) 接入uiuiAPI聚合平台教程 点开Models进行,在APIKeys点开,选择OpenAI APIKey进行配置...

2025/08/18

-

OpenAI o系列模型Responses接口开发Python代码示例 (1)

2025/07/23

-

精通AI编程工具:Claude Code 命令的高级技巧使用教程,提升您的开发效率~

2025/08/19

-

零门槛上手:获取OpenAI API Key用 GPT-5 打造你的私人 PDF 分析机器人( 附!Python代码)

2025/08/27

-

OpenAI API 实战教程:如何稳定获取结构化 JSON 输出

2025/08/26

-

OpenAI API Python实战教程:如何稳定获取结构化 JSON 输出(简易/复杂 双示例)

2025/08/26

-

权威开发者指南:Claude Code 安装与集成(附Windows详细安装教程)

2025/07/23

-

获取OpenAI API Key使用Python 调用Sora2文生视频开发(附代码)

2025/10/20

-

开源AI编码新王Void 凭什么成为Cursor的免费平替

2025/07/22

暂无评论

界智通

界智通  jieagi_Pan

jieagi_Pan

太好看了,快点更新!

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略

这是系统生成的演示评论

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略