OpenAI GPT-5 Pro 架构、性能与开发者获取API Key 集成全攻略

2025年8月7日北京时间凌晨,OpenAI揭开了其下一代旗舰模型GPT-5系统的神秘面纱,宣告了人工智能新纪元的到来。其核心亮点,在于一次彻底的架构革新:告别了过去“一招鲜”的单一通用模型,进化为一个能根据任务复杂度动态调度资源的“统一推理系统”。这意味着,无论是秒速响应的日常对话,还是深思熟虑的复杂分析,都能在同一平台内无缝实现。

作为该系统的巅峰之作,GPT-5 Pro 专为攻克高风险、高难度的推理任务而生,为精准与可靠设立了全新的行业标杆。在AIME(数学)、SWE-Bench(编码)及MMLU(常识推理)等多个权威基准测试中,GPT-5 Pro 的表现全面超越了前代GPT-4o及专用的o3推理模型,达到了SOTA(State-of-the-Art)水准。

对于开发者而言,全新的 v1/responses API端点不仅是接入GPT-5 Pro的唯一通道,更提供了一套前所未有的精细化控制工具。本文将带您深入探索GPT-5 Pro的技术内核,量化其惊人性能,并提供一份详尽的开发者实战指南——从获取API密钥到玩转函数调用与JSON模式,助您释放其全部潜能。GPT-5 Pro的诞生,正准备在智能体工作流、前沿科学研究及企业级自动化等领域扮演关键角色。

I. 架构深度解析:一个系统,两种心跳

1.1 理念之变:从“万能模型”到“协同系统”

GPT-5的问世,代表了OpenAI设计哲学的一次重大转变:从追求一个无所不包的“万能”单体模型,转向一个更加灵活、高效的多组件协同系统。用户不再需要在不同专长的模型间来回切换,GPT-5平台已将顶级的推理、多模态理解和任务执行能力融为一体,提供了前所未有的简化交互体验。

这种“先协作,后集成”的工程思路,其终极目标是打造一个能根据任务需求,自如权衡速度与深度的自适应AI。

1.2 双轨并行:快思的 “Main” 与慢想的 “Thinking”

这套统一系统建立在一个双轨核心之上,巧妙地模拟了人类的两种认知模式:

-

GPT-5-main (系统1 - 快思考): 这是系统的“快速通道”,专为低延迟、高吞吐量的日常查询和聊天场景优化。它处理着约80%的常规流量,提供即时、流畅的响应。

-

GPT-5-thinking (系统2 - 慢思考): 这是系统的“深度推理引擎”。当遇到需要严谨逻辑链(Chain-of-Thought)和多步分析的复杂难题时,系统便会唤醒它。该模型经过特殊强化训练,在给出答案前,会先在内部构建更长的推理路径,以确保逻辑的严密与答案的精准。

这种设计不仅吸收了此前“o系列”(如o1, o3)推理模型的精华,更将其能力无缝内置,让GPT-5既能“快言快语”,又能“深思熟虑”。

1.3 智能路由:按需分配的“中枢神经”

实时路由器是实现这套系统无缝体验的“中枢神经”。它像一位经验丰富的调度员,实时分析用户输入的提示,并依据查询的内在复杂性、上下文长度、是否需要调用外部工具,甚至是用户指令中的关键词(如“请仔细思考”、“一步一步来”)等多个维度,动态地将任务分配给最合适的模型。

更智能的是,路由器通过持续学习真实世界的产品信号(如用户反馈、模型切换行为)来不断自我优化。系统还内置了备用机制,当计算资源紧张时,会自动降级至对应的“迷你版”(mini)模型,确保服务的稳定与连续。

这套架构,是OpenAI为破解AI领域“成本、速度、能力”不可能三角难题所给出的战略答案。它承认并非所有任务都需要最强的“屠龙刀”,通过智能分流,用低成本的main模型高效处理海量简单请求,同时将宝贵的深度计算资源留给真正需要它的复杂任务。这不仅是技术创新,更是确保产品规模化运营下经济可行性的关键商业智慧。

1.4 核心技术增强

-

更优的Transformer架构: GPT-5 在Transformer的基础上,引入了分组查询注意力(GQA)和滑动窗口注意力(SWA)等机制,显著提升了长上下文处理效率与模型整体性能。

-

原生的多模态能力: 系统生而具备多模态基因,能在统一框架内同时理解文本与图像。通过API访问的Pro模型目前支持文本和图像输入,实现了比GPT-4o更深层次的跨模态推理。

-

革命性的40万Token上下文窗口: 这一飞跃意味着模型单次会话便能“读完”一整本书、一个大型代码库或数小时的会议纪要。对于开发者而言,这在很大程度上宣告了**检索增强生成(RAG)**复杂时代的终结。过去需要搭建向量数据库、实现复杂分块与嵌入逻辑才能处理的知识库,现在对于中等规模的静态数据,可以直接“喂”给模型,极大地简化了开发流程,降低了构建上下文感知AI应用的技术门槛。

表 1:GPT-5 模型家族速览

(为了方便开发者权衡性能、成本和速度,下表对GPT-5家族成员进行了对比。)

| 模型名称 | 核心优势 / 理想用例 | 推理水平 (定性) | 速度 (定性) | 输入价格 ($/1M tokens) | 输出价格 ($/1M tokens) | 上下文窗口 |

|---|---|---|---|---|---|---|

| gpt-5-pro | 高风险、高精度的复杂推理,如科学研究、金融分析、核心代码生成 | 最高 | 最慢 | $15.00 | $120.00 | 400,000 |

| gpt-5 | 跨领域的编码和智能体任务,平衡性能与成本的旗舰选择 | 较高 | 中等 | $1.25 | $10.00 | 400,000 |

| gpt-5-mini | 速度更快、成本更低的选项,适用于定义明确、复杂度中等的任务 | 中等 | 较快 | $0.25 | $2.00 | 400,000 |

| gpt-5-nano | 速度最快、成本最低的选项,适用于摘要、分类等轻量级实时任务 | 基础 | 最快 | $0.05 | $0.40 | 400,000 |

II. 性能与能力分析:新一代的绝对领跑者

2.1 定量分析:横扫各大基准测试

GPT-5用硬核数据证明了其代际领先优势:

-

数学与逻辑: 在高中竞赛级别的AIME 2025测试中,GPT-5无需工具辅助便达到94.6%的准确率,而 GPT-5 Pro 结合Python工具后更是实现了100%满分。这与GPT-4o约42.1%的表现形成云泥之别,标志着其在符号推理能力上的巨大飞跃。

-

编码与软件工程: OpenAI称其为“史上最强编码模型”。在衡量解决真实世界编程问题的SWE-Bench基准上,

gpt-5-thinking模式取得了**74.9%**的一次通过率,远超GPT-4(约52%)和o3模型(69.1%)。 -

通用知识与推理: 在MMLU测试中,GPT-5英文准确率超过90%,并在多语言版本中保持同等高水准(88-91%)。在考察博士级专业知识的GPQA基准上,GPT-5 Pro无需工具辅助即取得**88.4%**的高分。

-

多模态理解: 在MMMU基准测试中,GPT-5获得**84.2%**的分数,证明了其在图文混合理解任务中的顶尖实力。

表 2:基准性能对比:GPT-5 Pro vs. 前代模型

| 基准测试 | 任务描述 | GPT-4o | OpenAI o3 | GPT-5 (Thinking) | GPT-5 Pro |

|---|---|---|---|---|---|

| MMLU | 通用知识与推理 | \~86% | - | >90% | >90% |

| AIME 2025 | 高中数学竞赛 | 42.1% | 88.9% (无工具) | 94.6% (无工具) | 100% (带工具) |

| SWE-Bench Verified | 真实世界代码修复 | 30.8% | 69.1% | 74.9% | 74.9% |

| GPQA | 博士级专家问答 | 70.1% | 83.3% | 87.3% (带工具) | 88.4% (无工具) |

| MMMU | 多模态综合理解 | - | - | 84.2% | 84.2% |

2.2 定性提升:从“聪明”到“可靠”

在性能狂飙突进的同时,OpenAI将模型的可靠性与安全性提到了前所未有的战略高度。对于企业级应用,一个可信赖的模型远比一个“更聪明”的模型更有价值。

-

大幅减少“幻觉”: 这是GPT-5最核心的亮点之一。相比o3模型,

thinking模式下的事实性错误减少了80%,相比GPT-4o也减少了45%。这种可靠性的跃升,是其能够进入金融、医疗等高风险领域的入场券。 -

更强的指令遵循能力: 模型能更精准地理解并执行复杂、多步骤的指令,显著减少了“指令漂移”现象,这对于需要稳定执行任务的智能体工作流至关重要。

-

“安全补全”新理念: 面对敏感但合法的学术研究问题时,模型不再一味拒绝,而是提供安全的、高层次的指导性信息,在坚守安全底线的同时最大化其价值。

2.3 GPT-5 Pro:为终极推理而生

GPT-5 Pro的定位极其明确:专为攻克科学、数学、健康和编程领域中最具挑战性的推理任务而生的顶级模型。

其卓越性能的背后,是一种先进的“锦标赛式”推理架构。它在处理单个请求时,并非简单地“一条路走到黑”,而是可能并行运行多个推理链,再通过一个评估或综合步骤,选出或融合出最佳答案。这种类似集成学习(Ensemble)的方法,以更高的计算成本换来了无与伦比的鲁棒性与准确性。

根据OpenAI的评估,GPT-5 Pro产生的严重错误比标准thinking模式还要少22%。这一指标,对于高风险专业应用场景具有决定性意义。该模型仅通过v1/responses API提供,且强制锁定在最高的reasoning.effort: high设置,是整个家族中速度最慢、价格最高的旗舰。

III. 开发者指南:国内开发者openai api key获取与API 接入与集成

3.1 获取 API 密钥:四步通关

为帮助开发者快速上手,OpenAI设计了简洁明了的API接入流程:

方式A:官方直连模式

- 注册/登录账户: 访问OpenAI平台官网。

- 设置支付信息: 在“Billing”(计费)部分绑定有效的支付方式,激活API功能。

- 生成API密钥: 在“API keys”页面创建新密钥。务必注意:密钥仅在创建时完整显示一次,请立即复制并保存在安全之处。

- 安全存储密钥: 最佳实践是将其存储为环境变量(如

OPENAI_API_KEY),切勿硬编码在代码中。

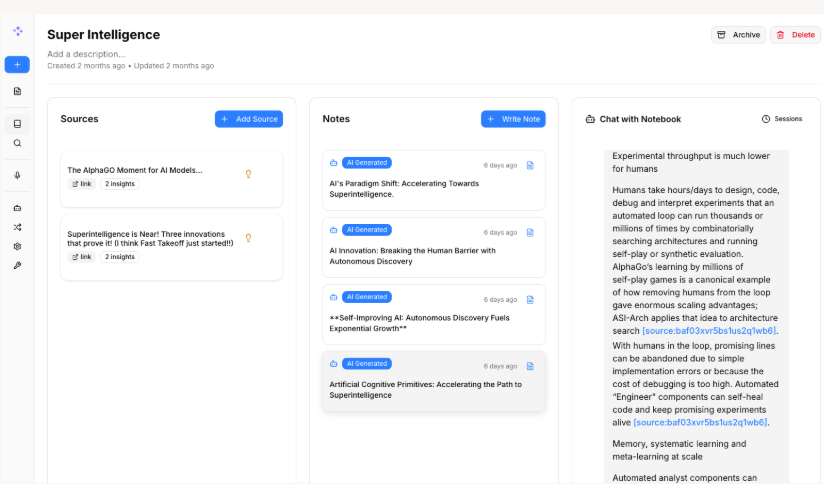

方式 B:国内加速模式

借助国内技术团队(如 uiuiapi.com)提供的中转服务,可显著提升连接稳定性与响应速度,适合通过AI聚合服务商获取 OpenAI或其他模型 API Key 的场景。使用前请确认服务商支持目标模型并评估其资质与隐私合规性。

3.2 环境配置与首次调用

确保安装最新版的官方库以兼容新功能:pip install --upgrade openai。

基础 Python 示例:

import os

from openai import OpenAI

# 客户端会自动从环境变量 "OPENAI_API_KEY" 读取密钥

client = OpenAI()

try:

response = client.responses.create(

model="gpt-5",

input="用中文写一首关于代码的五言绝句。"

)

print(response.output_text)

except Exception as e:

print(f"API 调用失败: {e}")基础 JavaScript (Node.js) 示例:

import OpenAI from "openai";

// 客户端会自动从环境变量 "OPENAI_API_KEY" 读取密钥

const openai = new OpenAI();

async function main() {

try {

const response = await openai.responses.create({

model: "gpt-5",

input: "Write a haiku about a server."

});

console.log(response.output_text);

} catch (error) {

console.error("API call failed:", error);

}

}

main();3.3 掌握 v1/responses:从“炼丹”到“遥控”

v1/responses是OpenAI为所有新项目推荐的统一端点,它整合并超越了旧API的功能,特别是GPT-5 Pro模型,只能通过此端点访问。

这次API的统一,标志着一个重要的转变:开发者不再仅仅依赖于复杂的提示工程(Prompt Engineering)来间接“ coaxing”模型,而是获得了直接、可预测的API级别控制能力。reasoning.effort和text.verbosity等新参数,就像是开放给开发者的模型内部“调节旋钮”,让你可以精确地管理速度、成本和质量的权衡。

核心参数:

model(string): 模型ID,如"gpt-5-pro"。input(string | array): 用户提示,支持多轮对话。reasoning.effort(string): 控制推理深度,可选"minimal","low","medium","high"(Pro模型强制为high)。text.verbosity(string): 控制输出详细程度,可选"low","medium","high"。instructions(string): 系统级指令,设定模型的角色和行为准则。

表 3:GPT-5 Pro API 快速参考 (v1/responses)

| 参数 | 数据类型 | 描述 | 可接受值 / 示例 |

|---|---|---|---|

model |

string | 必须。用于生成响应的模型 ID。 | "gpt-5-pro", "gpt-5" |

input |

string / array | 必须。用户的输入内容。 | "你好,世界!" |

reasoning.effort |

string | 可选。控制模型的推理深度和计算量。 | "minimal", "low", "medium", "high" |

text.verbosity |

string | 可选。控制响应的详细程度。 | "low", "medium", "high" |

instructions |

string | 可选。为模型提供系统级指令。 | "你是一个专业的软件工程师。" |

tools |

array | 可选。定义模型可以调用的外部函数。 | [{"type": "function",...}] |

response_format |

object | 可选。强制模型输出为特定格式,如 JSON。 | {"type": "json_object"} |

IV. GPT-5 Pro 高级 API 开发实战

4.1 玩转函数调用:构建智能工作流

函数调用是构建能与外部世界对话的智能体(Agent)的基石。它允许模型“请求”执行你定义好的代码(如查询数据库、调用天气API),并将结果整合进最终回答中。

GPT-5在工具使用的可靠性上显著提升,能更准确地解析函数签名,并支持更复杂的并行调用。

Python 示例:实现天气查询工具

import os

import json

from openai import OpenAI

client = OpenAI()

# 步骤 1: 定义你的工具

tools = [

{

"type": "function",

"function": {

"name": "get_current_weather",

"description": "获取指定地点的当前天气信息",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string", "description": "城市名,例如:'北京'"},

"unit": {"type": "string", "enum": ["celsius", "fahrenheit"]},

},

"required": ["location"],

},

},

}

]

# 模拟一个本地函数

def get_current_weather(location, unit="celsius"):

"""模拟获取天气的函数"""

if "北京" in location:

return json.dumps({"location": "北京", "temperature": "15", "unit": unit})

return json.dumps({"location": location, "temperature": "unknown"})

# 步骤 2: 调用模型

messages = [{"role": "user", "content": "现在北京天气怎么样?"}]

response = client.responses.create(

model="gpt-5-pro",

input=messages,

tools=tools,

tool_choice="auto",

)

# 步骤 3 & 4: 检查并执行工具调用,然后将结果反馈给模型

tool_calls = response.tool_calls

if tool_calls:

messages.append(response.message) # 将模型的回复(包含工具调用请求)加入历史

for tool_call in tool_calls:

function_name = tool_call.function.name

function_args = json.loads(tool_call.function.arguments)

if function_name == "get_current_weather":

function_response = get_current_weather(

location=function_args.get("location"),

unit=function_args.get("unit"),

)

messages.append(

{

"tool_call_id": tool_call.id,

"role": "tool",

"name": function_name,

"content": function_response,

}

)

# 再次调用模型以获得最终答案

final_response = client.responses.create(

model="gpt-5-pro",

input=messages,

)

print(final_response.output_text)4.2 JSON 模式:强制输出结构化数据

对于需要可靠、机器可读数据的应用,JSON模式至关重要。它能强制模型输出语法完全正确的JSON对象。

实现方法: 在API调用中设置 response_format={ "type": "json_object" },并在提示中清晰地描述你想要的JSON结构。

最佳实践: 在提示中提供一个“少样本”(few-shot)示例是引导模型生成正确结构的最有效方法。

Python 示例:从文本中提取结构化信息

from openai import OpenAI

import json

client = OpenAI()

prompt = """

从以下产品描述中提取关键信息,并严格按照指定JSON格式返回。

描述: '新款 Acme Widget 5000 配备了强大的 3.2 GHz 处理器和 16GB 内存,售价为 299.99 美元。'

JSON格式示例:

{

"product_name": "产品名称",

"specs": {

"cpu": "处理器规格",

"ram": "内存大小"

},

"price": 价格

}

"""

response = client.responses.create(

model="gpt-5-pro",

input=prompt,

response_format={"type": "json_object"},

)

# 解析并美化打印返回的JSON对象

parsed_json = json.loads(response.output_text)

print(json.dumps(parsed_json, indent=2, ensure_ascii=False))4.3 流式响应:实时应用的体验之道

流式响应(Streaming)允许你的应用在模型生成完整答案前,逐字逐句地接收和显示内容,极大降低用户的感知延迟。

重要提示:GPT-5 Pro 模型不支持流式传输。

这并非技术疏忽,而是一个刻意的产品设计决策。它清晰地传达了一个信息:GPT-5 Pro是用于异步、重度分析任务的引擎,而非实时交互聊天的工具。这种设计确保了开发者会将其用在最合适的场景——那些对深度和准确性要求极高,但对延迟不敏感的后台任务。

实现方法 (以 gpt-5 模型为例):

在 client.responses.create 调用中设置 stream=True。API将返回一个可迭代的事件流。

Python 示例:实时打印流式响应

from openai import OpenAI

client = OpenAI()

try:

# 使用支持流式传输的 gpt-5 模型

stream = client.responses.create(

model="gpt-5",

input="快速说十遍'灰化肥发黑会挥发'。",

stream=True,

)

print("模型响应:", end="")

for event in stream:

if event.type == "response.output_text.delta":

print(event.delta.text, end="")

print("\n流式传输结束。")

except Exception as e:

print(f"API 调用失败: {e}")

V. 战略影响与未来展望

5.1 行业变革:GPT-5 Pro 的潜力

凭借卓越的推理能力和可靠性,GPT-5 Pro将在多个关键行业掀起波澜:

- 金融: 自动从SEC文件中提取数据构建财务模型,加速尽职调查,进行复杂的风险评估,甚至将COBOL等古老代码库现代化。

- 医疗与生物技术: 在药物发现中提出新思路,作为医生的“第二意见”辅助诊断,自动化生成SOPs或分析临床数据,其表现在多项医疗基准测试中已超越人类专家。

- 高等教育: 成为师生的“博士级”研究助理,简化行政工作,创建永不疲倦的个性化虚拟助教。

- 娱乐与媒体: 生成高度个性化的营销文案,自动化创建完整的营销活动,在数小时内完成深度市场研究并提炼战略洞察。

对于企业而言,GPT-5 Pro的核心价值在于风险控制。其更高的准确率、更低的幻觉率,直接解决了前代模型部署于关键任务时的最大痛点——不可靠性。企业支付的溢价,买到的不仅是“更强的智能”,更是“更高的确定性”。

5.2 必须正视的局限与伦理

尽管进步巨大,但GPT-5远非完美,我们必须清醒地认识到其局限性:

- 幻觉依然存在: 虽然大幅减少,但模型仍可能生成看似合理实则错误的信息。在高风险应用中,人工监督依然是不可或缺的最后一道防线。

- 数据偏见: 模型会反映并放大训练数据中固有的社会偏见,部署时必须进行公平性审查。

- 提示依赖性: 输出质量极大程度上取决于输入的质量。尽管上下文窗口巨大,但在处理极端冗长或结构混乱的输入时,性能仍可能下降。

- AGI的误解: GPT-5仍是基于模式识别的复杂系统,不具备真正的理解、意识或自主决策能力。

5.3 GPT-5 之后:通往何方?

GPT-5的发布不是终点,而是通往更强大AI道路上的一个关键节点。未来的突破将更多来自算法创新,而非单纯的规模扩张。更先进的推理技术、工具使用框架将是关键方向。随着AI能力持续增强,它将对就业、商业乃至社会结构产生深远影响,关于数据隐私、知识产权和监管的讨论将愈发紧迫。AI究竟是增强人类,还是最终取代人类?这场辩论,才刚刚开始。

版权信息: 本文由界智通(jieagi)团队编写,图片、文本保留所有权利。未经授权,不得转载或用于商业用途。

本文发布于2025年10月13日22:25,已经过了113天,若内容或图片失效,请留言反馈 转载请注明出处: 界智通

本文的链接地址: https://www.jieagi.com/aizixun/82.html

-

2025最新:Claude Pro 与 Max 区别详解与订阅指南

2025/08/26

-

Cursor权威指南:从注册入门到精通AI驱动编程工作流(含国内注册与验证说明)

2025/08/27

-

Gemini 报错 "Something went wrong" 终极解决指南

2025/11/27

-

GPT-5-Codex保姆级教程:获取OpenAI APIKey与安装 Codex CLI使用教程全面指南

2025/09/17

-

【实测有效】Gemini 3 / Google Antigravity 授权登录无反应、无权限?全平台解决办法汇总指南

2025/11/22

-

2025最新保姆级教程:如何获取Claude API Key?从注册到Python调用,一篇搞定!

还在为如何申请 Claude API Key 而头秃吗?随着 Claude 4.5 Sonnet 在编程能力上的强势崛起,越来越多的开发者开始转向 Anthropic 的阵营。本文将通过“保姆级”的图文实操,带你一步步解决账号注册、手机号验证、API Key 获取及额度充值等难题,并附带 Python 极简调用示例。无论你是想接入 LangChain 还是自己在这个强大的模型上跑 Demo,这篇文章都能帮你避开 99% 的坑!

2025/11/15

-

OpenAI GPT-5 深度解析:API Key定价与ChatGPT(Free, Plus, Pro)用户的区别

2025/08/08

-

OpenAI GPT-5 定价与功能对比:API Key 与 ChatGPT 各版本全解析

2025/08/10

-

Claude订阅避坑指南:Pro还是Max?看完这篇再决定!

2025/08/26

-

深度解析 Gemini 2.5 Flash Image Preview:API Key 获取、核心能力与多模态调用实践

2025/09/09

暂无评论

界智通

界智通  jieagi_Pan

jieagi_Pan

太好看了,快点更新!

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略

这是系统生成的演示评论

国内开发者玩转Claude:最新Claude 4模型解析与API Key获取攻略